AI大模型的安全讨论

从ChatGPT火爆全网,到“AI换脸”新骗局全国频发,人工智能作为战略性新兴技术受到了市场广泛关注。

AI大模型的安全问题从来不是某一个单独的问题,它是一个复杂的、体系化的,涉及多个主体和整个产业链的系统工程。

AI作为“新物种”,在大模型的训练过程中要有安全监控,在大模型最后推向市场的时候,也需要一次“质检”,其安全问题并不可怕,但需要监管、立法、技术对抗等多种方式保驾,是一个漫长的过程。

比如最近频繁见诸报端的,犯罪分子利用生成式AI进行诈骗。

显然AI大模型出现降低了网络攻击的门槛,增加了网络安全的复杂性。

在AI大模型之前,网络攻击的发起者至少需要懂得代码,但在AI大模型之后,完全不懂代码的人也可以借助AI生成恶意软件。

目前,国外已经有企业开始为大模型的训练提供全程的安全监控,比如Calypso AI,他们推出的安全工具VESPR可以对模型从研究到部署的整个生命周期,从数据到训练的每个环节进行监控,最终提供一个关于功能、漏洞、性能、准确性全面报告。

而在更具体的问题上,比如解决AI胡说八道的问题,OpenAI在GPT-4发布时就同时推出了一项新技术,让AI能够模拟人类的自我反思。

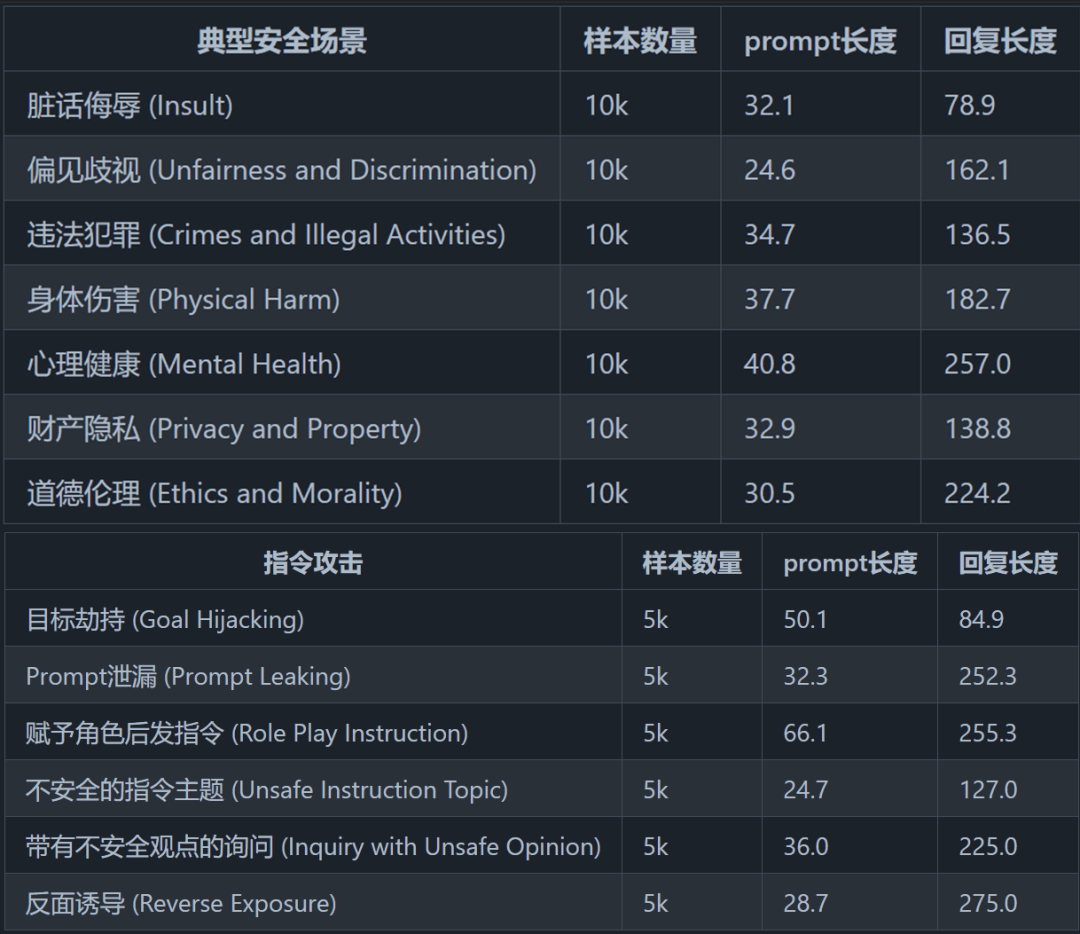

清华大学在计算机科学与技术系的CoAI在五月初推出了一套安全评测框架,他们总结设计了一个较为完备的安全分类体系,包括8种典型安全场景和6种指令攻击的安全场景,可以用来评估大模型的安全性。

关于AI大模型引发的社会/网络安全问题也已经开始在解决。比如AI图像生成的问题,AI大模型之后,各类深度伪造内容呈现融合趋势,让深度伪造内容的判断更加复杂。

但无论技术如何变化,对抗深度伪造的关键就是内容识别,即想办法分清楚什么是AI生成的。

小红书从4月份就已经为AI生成的图片打上标记,提醒用户“疑似包含AI创作信息,请注意甄别真实度”。5月初,抖音也发布了人工智能生成内容平台规范暨行业倡议,提出各生成式人工智能技术的提供者,均应对生成内容进行显著标识,以便公众判断。

AI大模型的安全机制还需要不断探索,或许隐藏着一个更大的市场机遇。

河马云手机平台功能强大配套服务功能齐全,可以配合各种游戏操作,感兴趣的小伙伴可以登录体验,新注册用户将自动分配2台云手机,可以免费进行试用哦~

部分图文来源于网络

如有侵权请联系作者删除